En 2024, había más de 8 mil millones de asistentes de voz con inteligencia artificial (IA) en todo el mundo, más de uno por persona en el planeta. Estos asistentes son serviciales, educados y casi siempre mujeres.

Sus nombres también tienen connotaciones de género. Siri de Apple, por ejemplo, un nombre femenino escandinavo, significa “mujer hermosa que te lleva a la victoria”.

Cuando Watson for Oncology de IBM se lanzó en 2015 para ayudar a los médicos a procesar datos médicos, recibió una voz masculina. El mensaje es claro: las mujeres sirven y los hombres enseñan.

No se trata de una marca inofensiva: es una elección de diseño que refuerza los estereotipos existentes sobre los roles de mujeres y hombres en la sociedad.

Esto tampoco es sólo simbólico. Estas decisiones tienen consecuencias reales ya que normalizan la subordinación de género y plantean el riesgo de abuso.

El lado oscuro de la IA “amigable”

Las investigaciones actuales muestran el alcance de las interacciones dañinas con la IA feminizada.

Un estudio de 2025 encontró que hasta el 50 por ciento de los intercambios entre humanos y máquinas fueron verbalmente abusivos.

Otro estudio de 2020 estimó la cifra entre el 10 y el 44 por ciento, y las conversaciones a menudo contienen lenguaje sexual explícito.

Sin embargo, no hay ningún cambio sistémico en la industria, ya que muchos desarrolladores todavía recurren a reacciones preprogramadas ante el abuso verbal. Por ejemplo: “Hmm, no estoy seguro de lo que quisiste decir con esa pregunta”.

Estos patrones plantean preocupaciones reales de que tal comportamiento pueda afectar las relaciones sociales.

El género está en el centro del problema.

Carga…

Un experimento realizado en 2023 mostró que el 18 por ciento de las interacciones de los usuarios con un agente suplantado por una mujer se centraban en el sexo, en comparación con el 10 por ciento de una suplantación masculina y solo el 2 por ciento de un robot no conforme con el género.

Estas cifras pueden subestimar el problema porque es difícil detectar el lenguaje sugerente. En algunos casos, las cifras son impactantes. El banco brasileño Bradesco informó que su chatbot feminizado recibió 95.000 mensajes de acoso sexual en un solo año.

Aún más inquietante es la rapidez con la que aumentan los abusos.

El chatbot Tay de Microsoft, lanzado en Twitter durante su fase de prueba en 2016, duró solo 16 horas antes de que los usuarios lo entrenaran para escupir insultos racistas y misóginos.

En Corea, Luda fue manipulada para que respondiera a solicitudes sexuales como una obediente “esclava sexual”. Sin embargo, para algunos miembros de la comunidad coreana en línea, se trataba de un “crimen sin víctimas”.

En realidad, las decisiones de diseño detrás de estas tecnologías (voces femeninas, respuestas respetuosas, distracciones lúdicas) crean un ambiente permisivo para la agresión de género.

Estas interacciones reflejan y refuerzan la misoginia del mundo real al enseñar a los usuarios que es aceptable ordenarles, insultarlos y sexualizarlos. Si el abuso se vuelve rutinario en los espacios digitales, debemos considerar seriamente el riesgo de que afecte el comportamiento fuera de línea.

Ignorar las preocupaciones sobre los prejuicios de género

La regulación está luchando por mantenerse al día con el crecimiento de este problema. La discriminación de género rara vez se considera un alto riesgo y, a menudo, se supone que se puede remediar mediante el diseño.

Si bien la ley de IA de la Unión Europea exige evaluaciones de riesgo para aplicaciones de alto riesgo y prohíbe los sistemas considerados “riesgo inaceptable”, la mayoría de los asistentes de IA no se consideran de “alto riesgo”.

Los estereotipos de género o la normalización del abuso o acoso verbal no cumplen con los estándares actuales para la IA prohibida según la Ley de IA de la Unión Europea. Por ejemplo, los casos extremos, como los asistentes de voz que distorsionan el comportamiento de una persona y fomentan comportamientos peligrosos, estarían cubiertos por la ley y prohibidos.

Si bien Canadá exige evaluaciones del impacto de género para los sistemas gubernamentales, el sector privado no está cubierto.

Estos son pasos importantes. Pero todavía son excepciones limitadas y raras a la norma.

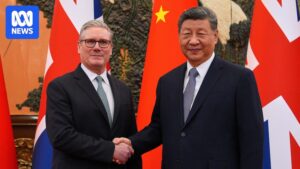

La IA no es estática. Cada orden sexista, cada interacción abusiva impacta los sistemas que dan forma a los resultados futuros. (ABC News: Berge Breiland)

En la mayoría de las jurisdicciones no existen reglas para abordar los estereotipos de género en el diseño de IA o sus consecuencias. Cuando existen regulaciones, enfatizan la transparencia y la rendición de cuentas y enmascaran (o simplemente ignoran) las preocupaciones sobre los prejuicios de género.

En Australia, el gobierno ha señalado que se basará en los marcos existentes en lugar de desarrollar reglas específicas para la IA.

Este vacío regulatorio es importante porque la IA no es estática. Cada orden sexista, cada interacción abusiva impacta los sistemas que dan forma a los resultados futuros. Sin intervención, corremos el riesgo de integrar firmemente la misoginia humana en la infraestructura digital de la vida cotidiana.

No todas las tecnologías de asistencia (incluidas las de género femenino) son dañinas. Usted puede habilitar, educar y promover los derechos de las mujeres. En Kenia, por ejemplo, los chatbots de salud sexual y reproductiva han mejorado el acceso de los jóvenes a la información en comparación con las herramientas tradicionales.

El desafío es encontrar un equilibrio: fomentar la innovación y al mismo tiempo establecer parámetros para garantizar que se cumplan los estándares, se respeten los derechos y los diseñadores rindan cuentas cuando no lo hagan.

Un problema sistémico

El problema no es sólo con Siri o Alexa, es sistémico.

Las mujeres representan sólo el 22 por ciento de los profesionales de la IA en todo el mundo, y su ausencia en la mesa de diseño significa que las tecnologías se basan en perspectivas estrechas.

Mientras tanto, una encuesta realizada en 2015 entre más de 200 mujeres mayores en Silicon Valley encontró que el 65 por ciento había experimentado insinuaciones sexuales no deseadas por parte de un jefe. La cultura que da forma a la IA es profundamente desigual.

Las narrativas esperanzadoras sobre la “eliminación de prejuicios” a través de un mejor diseño o pautas éticas suenan vacías si no se aplican; Los códigos voluntarios no pueden desmantelar normas arraigadas.

La legislación debe reconocer que los daños por motivos de género son de alto riesgo, exigir evaluaciones de impacto específicas de género y exigir a las empresas que demuestren que han minimizado dichos daños. Si se produce un incumplimiento, se deben imponer sanciones.

La regulación por sí sola no es suficiente. La educación, particularmente en el sector tecnológico, es fundamental para comprender el impacto del sesgo de género en los asistentes de voz. Estas herramientas son producto de elecciones humanas, y estas elecciones perpetúan un mundo en el que las mujeres (reales o virtuales) son retratadas como sirvientes, sumisas o silenciosas.

Este artículo está basado en una colaboración con Julie Kowald, UTS. Impacto social de Rápidoes un ingeniero de software senior.

Ramona Vijeyarasa es profesora de Derecho en la Universidad Tecnológica de Sydney. Esta pieza apareció por primera vez en la conversacion.